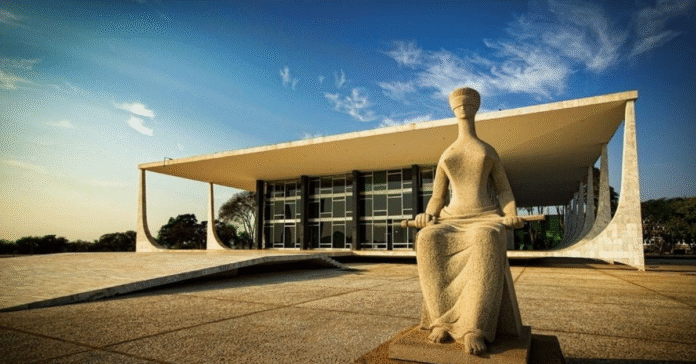

STF retoma julgamento que define regras para redes sociais e conteúdos ilegais

O Supremo Tribunal Federal (STF) retoma nesta quarta-feira (4), às 14h, o julgamento sobre a responsabilidade das redes sociais por conteúdos ilegais publicados por usuários. O ministro André Mendonça, que havia solicitado vista em dezembro de 2023, será o primeiro a votar.

A sessão pode influenciar diretamente como as plataformas digitais operam no país, especialmente diante do crescente volume de desinformação, crimes virtuais e discursos de ódio.

Marco Civil da Internet volta ao centro do debate jurídico

O plenário analisa a constitucionalidade do Artigo 19 da Lei 12.965/2014, conhecida como Marco Civil da Internet. O dispositivo determina que as plataformas só respondem judicialmente se não removerem o conteúdo ilegal após receberem uma ordem judicial.

Esse modelo visa proteger a liberdade de expressão e evitar a censura prévia, garantindo que decisões sobre remoção de conteúdo partam do Judiciário.

Três ministros já apresentaram seus votos no processo

Até o momento, três ministros se manifestaram:

-

Luís Roberto Barroso, presidente do STF, defendeu uma responsabilização parcial das plataformas. Ele propôs a remoção imediata, após notificação, de conteúdos como:

-

pornografia infantil;

-

incentivo ao suicídio;

-

tráfico de pessoas;

-

terrorismo;

-

ataques à democracia.

Por outro lado, Barroso considera que crimes contra a honra e postagens ofensivas devem continuar dependendo de decisão judicial, como prevê a legislação atual.

-

-

Dias Toffoli e Luiz Fux adotaram uma posição mais ampla. Ambos defenderam que as plataformas devem remover conteúdos ilegais mediante notificação extrajudicial, sem necessidade de ordem judicial. Eles citaram como exemplos:

-

incitação à violência;

-

racismo;

-

ameaças à democracia.

-

Dois processos analisam limites legais para redes sociais

O STF julga dois recursos distintos relacionados ao mesmo tema:

-

O primeiro caso, sob relatoria de Dias Toffoli, envolve um recurso do Facebook. A empresa tenta reverter uma condenação por danos morais relacionada à criação de um perfil falso.

-

O segundo processo, relatado por Luiz Fux, trata de um recurso do Google. A empresa questiona se deve monitorar e remover conteúdos ofensivos sem ordem judicial.

Ambos os casos testam os limites entre liberdade de expressão, dever de moderação e responsabilidade legal das plataformas.

Empresas digitais defendem modelo atual

Durante as sessões anteriores, representantes das redes sociais defenderam o modelo vigente, no qual a responsabilização ocorre apenas após descumprimento de decisão judicial.

Eles alegaram que exigências mais rígidas poderiam configurar censura prévia e prejudicar o direito à livre manifestação. Além disso, destacaram que já realizam remoções extrajudiciais voluntárias, especialmente em casos graves.